Address

304 North Cardinal

St. Dorchester Center, MA 02124

Work Hours

Monday to Friday: 7AM - 7PM

Weekend: 10AM - 5PM

Address

304 North Cardinal

St. Dorchester Center, MA 02124

Work Hours

Monday to Friday: 7AM - 7PM

Weekend: 10AM - 5PM

Advantech MIC-743-AT-ES,搭載最新 NVIDIA® Jetson Thor™ 模組,我們好奇:一台邊緣 AI 系統,真的能在本地端「扛得起」百億參數等級的模型嗎?

我的ESP32實做書籍:我出書了 ESP32 物聯網專題

博客來網址:https://www.books.com.tw/products/0010901195

今天才剛要出門就踢到大箱子,看一下誰寄來的,竟然是國際工業電腦大廠研華科技寄來的箱子,喔喔喔~實在太令人興奮了,不會是乾爹皮衣男口中所說的最新產品雷神吧,趕緊提回家開箱看看。

開啟箱子,看到一台沉甸甸的工業電腦,第一眼看到的就是 MIC-743-AT-ES 的正面外觀。

【整體】外型延續了工業電腦一貫的沉穩設計,霧黑色金屬機殼搭配 Advantech Logo,簡潔而專業。上蓋還覆有保護膜,避免在運輸過程中刮傷,保持開箱時的嶄新質感。

【正面】則是低調的研華科技的LOGO,沒有其他的裝置,果然國際大廠就是這麼豪橫。

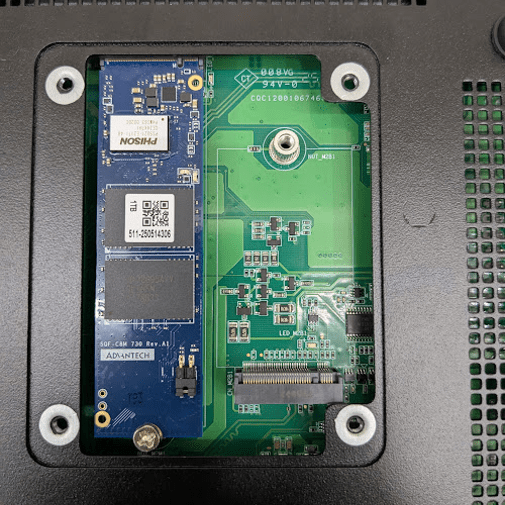

【底部】的開口可以看到NVMe的插槽,竟然也是研華的產品,這次提供測試的容量為1T的SSD,右側為M2接口,可外接WIFI傳輸模組提升傳輸能力。

【側邊】還有 SIM 卡槽與一系列控制按鍵,包括 REC、OTG、RST 以及 Console 接口,讓使用者能夠快速進行調試與功能驗證,為甚麼會有SIM 卡呢?這台又不是手機,當然是可以提供4/5G傳輸功能,在沒有WiFi的場域也可以存取網路或者進行遠端控制。

轉到【機身背面】,這台主機的 I/O 接口算是相當齊全:

完成機體賞析後,我們就插電開機準備來測試他的效能, Advantech MIC-743-AT-ES,搭載最新 NVIDIA® Jetson Thor™ 模組,我們好奇:一台邊緣 AI 系統,真的能在本地端「扛得起」百億參數等級的模型嗎?在測試之前,先看看 NVIDIA Jetson AGX Thor (Dev Kit) 規格。雖然我們這次實測的是 研華 MIC-743-AT-ES,用的是NVIDIA Jetson Thor 模組: NVIDIA Jetson T5000打造的研華系統,而非NVIDIA Jetson AGX Thor Dev Kit,但同屬 Thor 世代,因此拿官方 NVIDIA Jetson AGX Thor 的數據來做參照,可以幫助大家理解這一代的性能基準。

功耗 (Power):40 W 至 130 W。

這次NVIDIA Jetson AGX Thor 的 AI 邊緣運算裝置是具有在於 2560 核心 GPU 與 96 顆 Tensor 核心,支援 MIG[Multi-Instance GPU] 可將單卡切成多個獨立執行體,同時跑多模型、強化資源隔離。

14 核 Arm Neoverse-V3AE CPU[CPU] 搭配 128 GB LPDDR5X、273 GB/s 頻寬,確保大量視覺與感測資料即時進出;再加上 PVA v3 視覺加速器,能把前處理/光流等卸載。1 TB NVMe[NVMe] 讓資料快取與模型切換順暢;40–130 W 功耗區間適合邊緣裝置在受限電力下仍維持高吞吐推論與低延遲控制。

與上一代的Orin的差異可以說非常大

下面是NVIDIA Jetson Orin Nano™ Super(8GB/ Dev Kit) 與 NVIDIA Jetson AGX Thor (Dev Kit) 在「運算」面向的對照表。

依照規格比較 NVIDIA Jetson Thor 以 Blackwell 架構與 MIG 帶來資料中心級的邊緣算力(2070 FP4 TFLOPS),同時具備更高記憶體與頻寬,適合大型多模型與生成式工作負載。

但是實際上到底如何呢?這次,我們直接把 GPT-OSS 120B 丟上 MIC-743-AT-ES,一款搭載 NVIDIA Jetson Thor 模組的 AI 推理系統,實測它的真實表現。

我分別載入兩款 GPT-OSS 模型(20B 與 120B)用 Ollama 本地推理測試其效能:

在實際測試 GPT-OSS 20B 的時候,整體體驗可以說是相當順暢。

平均總耗時大概在 7 秒多,載入時間更是不到 150 毫秒,幾乎可以忽略不計。Prompt 部分處理了將近 500 個 tokens,但評估只花了 0.04 秒,等於一秒能吞掉快四萬個 token,效率驚人。生成階段平均輸出 410 個 tokens,大概 7 秒就跑完,換算下來生成速度穩定在 58.5 tokens/s,對於互動式應用來說,這已經是非常理想的表現。

相較之下,GPT-OSS 120B 的表現雖然慢了一些,但依舊讓人印象深刻。平均總耗時來到 45 秒左右,其中載入時間大概 0.24 秒,雖然比 20B 稍長,不過放在百億級別模型的規模裡,這樣的開局速度其實算很快了。Prompt 部分一次處理超過 1600 個 tokens,光是評估就花了 1.65 秒,效率自然沒辦法和 20B 相提並論。不過生成過程輸出了 1500 多個 tokens,平均速度維持在 35 tokens/s,以 120B 的龐大參數量來看,能在邊緣端跑出這個數字,真的非常驚人。

簡單來說,20B 適合即時互動,速度快、延遲低;120B 則是給需要更高語言理解力和更深度推理的場景使用。兩者的表現剛好形成了「速度 vs. 智慧密度」的對比,取決於在不同應用中要優先考慮哪一個。

詳細數據如下

當我輸入「哈囉你好」後,模型不僅正確理解語境,還貼心地補了一句「有什麼我可以幫忙的嗎?😊」。

這種自然的互動讓人有種「真的在本地端跑超大模型」的震撼感。

雖然目前效能不算極致,但能夠離線、隨時喚起這樣的語言模型,本身就是一種里程碑。

有趣的是,在模型回應過程中 CPU 幾乎沒有被吃滿,顯示運算核心可能主要落在 GPU,CPU 只負責周邊調度。另一方面,記憶體吃掉 75GB,這和 GPT-120B 這樣的龐大參數量完全符合預期。

這也意味著,想在本地端玩 120B 模型,沒有 128GB 以上記憶體 幾乎不用考慮。

為了更全面觀察NVIDIA Jetson Thor 在不同模型下的表現,我們針對多款 LLM 做了推理速度,整理如下:

從這份數據看下來,其實趨勢滿明顯的:模型參數越大,生成速度自然就慢下來。不過有趣的是,像 GPT-OSS 120B 這樣的百億等級模型,還能穩定跑到 35 token/s,這表現已經超乎預期,算是驚艷了。

反觀小模型的優勢就更直接了,像 GPT-OSS 20B 和 Llama3.2 8B,速度可以衝到 38 到 58 token/s,對需要即時互動或低延遲場景來說,絕對是首選。

至於 DeepSeekR1 系列,8B 還算能接受,但 70B 就有點太吃力了,速度掉到只剩 4.81 token/s,幾乎無法用在即時應用上。

整體測下來,Jetson Thor 在本地推理百億等級模型時,效能的確帶來了驚喜。像 GPT-OSS 120B 這樣的龐然大物,依然能穩定輸出約 26 tokens/s,在生成任務裡已經屬於中高水準,完全超乎我的預期。從資源使用來看,記憶體雖然吃掉約 57%,但仍保留餘裕,這意味著未來能支援更長上下文,甚至額外的並行任務。更令人驚喜的是 CPU 幾乎沒有壓力,主要運算全交由 GPU 與 Tensor Core 負責,展現出專用 AI 加速器的真正價值:它不是靠「燃燒 CPU」硬撐,而是把工作交給最適合的硬體來處理。

更重要的是,這台 MIC-743-AT-ES 成功證明了一件事:在邊緣端要跑超大規模模型,已經不再是不可能的任務。它不只能撐起 120B 參數的 LLM,還能保持實用的推理速度,為各種應用場景打開新的大門,我們這裡列出幾個未來可以應用的場景:

總結來說,Jetson Thor 不只是「效能強大」這麼簡單,而是把原本需要龐大伺服器與雲端支撐的 LLM,縮小到能放在邊緣裝置上使用。這種突破,不只是提升了 AI 的可及性,也象徵「AI 不再遙遠,而是隨時隨地」。未來,不論在工廠、街頭、醫院,甚至小型辦公室,你都可能遇到一台「隱藏著百億模型的黑盒子」,默默地支撐著各種智慧應用的運行。

| 應用領域 | 典型需求/挑戰 | Jetson Thor 解決方式與價值 |

| 智慧製造 | 瑕疵檢測需即時、機器手臂需自主判斷 | 本地跑 20B/120B 模型,即時影像+語言推理,減少雲端延遲 |

| 智慧交通 | 自駕車決策、智慧號誌、突發狀況應變 | 邊緣即時處理多路影像與感測數據,提供低延遲決策支援 |

| 醫療應用 | 影像判讀、病歷摘要、隱私保護 | 本地部署大型 LLM,提升診斷效率,並確保敏感資料不外流 |

| 智慧城市/安防 | 即時監控、異常偵測、緊急事件反應 | 本地推理多模態數據,快速偵測與通報,減少傳輸瓶頸 |

| 企業邊緣運算 | 高安全需求(金融/國防/能源),決策輔助 | 內網部署大模型,兼顧高效能與資訊安全,避免資料外洩 |

| 教育與研發 | 研究需低成本試驗,雲端 GPU 依賴度高 | 在實驗室本地運行百億模型,降低門檻,快速迭代試驗 |

請問在做速度測試時,每個模型都是量化成FP4嗎?

是,歡迎討論